Databricks data intelligence platform – dit vinden wij ervan

Meer dan een jaar na de naamswijziging van ‘lakehouse platform’ naar ‘Databricks data intelligence platform’ zit Databricks middenin een grootse transformatie. Dat betekent een flinke vernieuwing van het populaire data management platform.

Welk ontwikkelingen zijn er? En wat vinden de solution architecten en data engineers van Riviq daarvan?

In dit blog zetten we dat helder en hoog over uiteen, speciaal voor IT- of data managers.

Bij Riviq zijn we fan van Databricks. We gebruiken dit cloud platform voor data management bij veel van onze klanten, vrijwel dagelijks.

Ook schreven we eerder al een blog over hoe je performance problemen kunt voorkomen in Databricks. We zijn dan ook blij met de frisse wind die door het platform gaat.

Overigens introduceerde Databricks de beweging naar een data intelligence platform eind 2023 al. Dat is gedreven door een groeiende behoefte aan meer geavanceerde en geïntegreerde data-oplossingen dan het lakehouse model bood. En wellicht ook door concurrentie, zoals Microsoft Fabric.

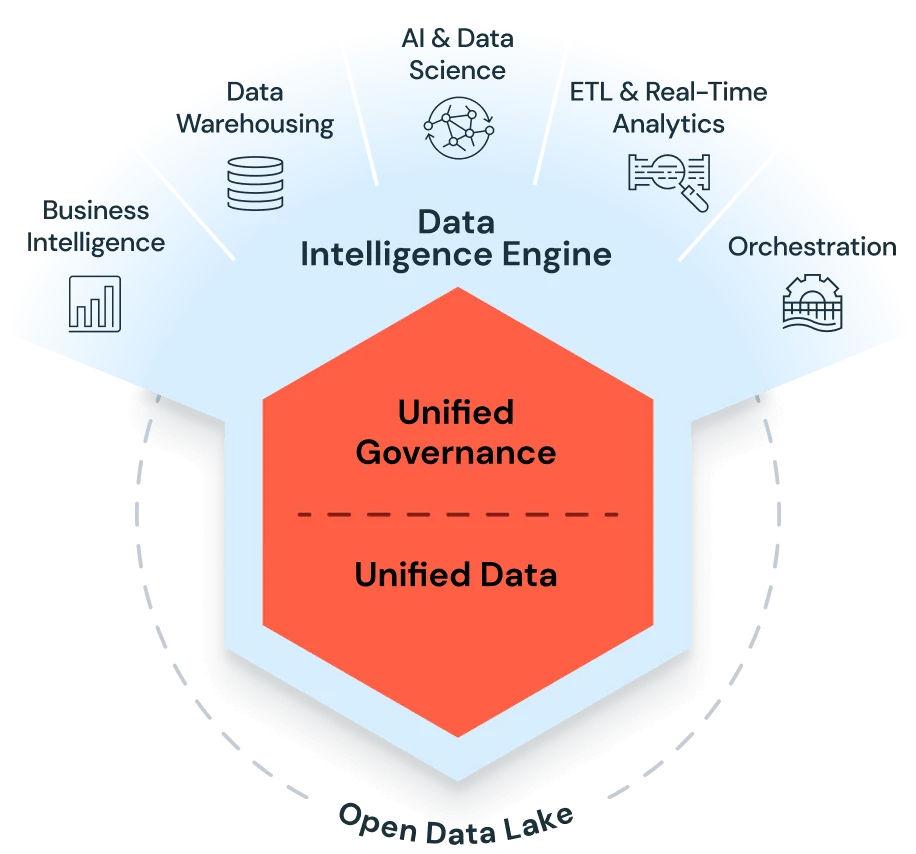

Wat we nu zien gebeuren, is samen te vatten in twee ontwikkelingen: de introductie van AI en de toevoeging van veel nieuwe functionaliteiten.

De komst van AI werkt twee kanten op. Enerzijds om de bestaande lakehouse en data governance functionaliteiten te verbeteren en uit te breiden. Anderzijds biedt het platform gebruikers mogelijkheden voor het ontwikkelen, beheren, implementeren en monitoren van generatieve AI-modellen en -applicaties.

De sterke uniforme en geïntegreerde aanpak voor governance en beveiliging van Databricks blijft overigens onveranderd.

Naast de nieuwe en verbeterde functionaliteiten die de integratie van AI mogelijk maakt, zien we ook dat Databricks het platform in een hoog tempo uitbreidt met extra functionaliteiten voor data management en governance. Functionaliteiten die Databricks eerst niet had.

Denk aan end-to-end ondersteuning van het bouwen, implementeren, delen en onderhouden van data-, analyse- en AI-oplossingen. Daarmee wordt Databricks meer en meer een one-stop-shop.

Explosieve uitbreiding van functionaliteiten

We zien nu al concrete veranderingen binnen Databricks. In een later blog duiken we in het uitgebreide aanbod voor generatieve AI-modellen en -toepassingen. Nu kijken we naar een aantal opvallende, nieuwe en goed bruikbare functionaliteiten die we al hebben kunnen testen.

Dus of je Databricks nu al gebruikt óf erover nadenkt ermee aan de slag te gaan: dankzij dit overzicht weet jij als IT- of data manager wat je kunt verwachten.

De volgende functionaliteiten zijn al beschikbaar of in public preview:

Functionaliteiten voor data engineering

Scheduling en orchestration

Vaak zien we nog ETL, analytics en AI/ML pipeline architecturen waarbij er voor scheduling en orchestration tools zoals Apache Airflow of Azure Data Factory wordt gebruikt voor Databricks only pipelines. Het nieuwe Databricks Workflows kan deze externe tools volledig vervangen. Het biedt een gelijkwaardige – of zelfs betere – functionaliteit mét volledige integratie in het Databricks-platform.

Data-extractie

Azure Data Factory is de standaard tool voor brondata-ontsluitingen in veel lakehouse architecturen in Microsoft Azure Cloud. Het nieuwe, nog in public preview zijnde, LakeFlow Connect kan op termijn de standaardtool worden voor deze brondata-ontsluitingen.

Databricks ETL-framework

Delta Live Tables (DLT) is een ‘declarative framework’ om eenvoudig betrouwbare en onderhoudbare ETL-pipelines te creëren. Dankzij de verbeterde functionaliteit kan een data engineer nu beter aan de slag met data kwaliteit en consistentie, het verwerken van streaming- en batchgegevens op een uniforme manier, schaalbaarheid en performance en het wijzigen schema’s en business rules.

CI/CD ondersteuning

Databricks’ nieuwe functionaliteit ‘Asset Bundles’ is een tool om software engineering projecten eenvoudiger te maken. Namelijk door best practices te gebruiken op het gebied van broncodebeheer, code reviews, testen en continuous integration and delivery (CI/CD). Bundles bestaan uit Databricks-objecten zoals workflow, jobs, notebooks, DLT-pipelines, MLflow-experimenten en -modellen en dashboards in de vorm van een bestand. De objecten kunnen geïmplementeerd worden samen met metadata voor bijvoorbeeld de benodigde infrastructuur.

Coderen met AI

Databricks heeft een eigen, volledig geïntegreerde ‘Copilot’, een op AI gebaseerde ‘pair-programmer’ en ondersteuningstool. Het kan je helpen snel vragen te beantwoorden door code en queries te genereren, optimaliseren, uit te leggen en te corrigeren.

Business intelligence

Databricks AI/BI Dashboards (voorheen Lakeview dashboards) is een AI-powered, low-code business intelligence product voor dashboarding. Het omvat alle conventionele BI-mogelijkheden en maakt datavisualisatie veel eenvoudiger.

Meer van dit in je mailbox?

We sturen je circa 6x per jaar een email met handpicked cases, blogs en tips.

Databricks Unity Catalog

Databricks Unity Catalog biedt een governance-tool voor data en AI op het Databricks Intelligence-platform.

Met Unity Catalog kun je zowel gestructureerde als ongestructureerde gegevens in elk formaat beheren, evenals machine learning- en AI-modellen, notebooks, dashboards en bestanden, ongeacht de cloud of het platform.

Unity Catalog is niet nieuw, maar het is belangrijk om te weten dat de meeste toekomstige en verbeterde functionaliteiten niet beschikbaar zijn zonder dat de betreffende data- en AI-objecten door Unity Catalog worden beheerd. Databricks-implementaties zonder Unity Catalog worden als legacy beschouwd.

Hive Metastore Federation

Deze nieuwe functionaliteit is in public review en maakt het mogelijk om tabellen uit bestaande (legacy) Hive metastores onder de governance van Unity Catalog te brengen. Dit biedt een stapsgewijze migratie zonder dat er codewijzigingen nodig zijn.

Databricks Observability met Unity Catalog systeemtabellen

De systeemtabellen van Unity Catalog zijn een nieuwe functionaliteit waarin automatisch alle operationele platformactiviteiten en data lineage-informatie worden gelogd. Deze tabellen kunnen worden gebruikt voor monitoring en analyse op het gebied van:

- Gebruikersactiviteit en toegang (audit logging)

- Jobprestaties en -kwaliteit

- Kostenanalyse en toekomstig gebruik (gedetailleerd en geaggregeerd)

- Query-prestaties en -kwaliteit

- Tabel- en kolom-lineage

Dit helpt bij het verminderen van infrastructuurkosten, het optimaliseren van het platform en het onderhouden van datastromen en pipelines.

Lakehouse monitoring

Een uniforme oplossing voor het monitoren van datakwaliteit en AI-prestaties in de hele data pipeline. Statistische eigenschappen en de kwaliteit van tabellen in Unity Catalog worden gemonitord, waarbij automatisch dashboards worden gegenereerd met de resultaten.

Predictive optimization

Een nieuwe AI-gestuurde functionaliteit die automatisch tabellen, beheerd door Unity Catalog, optimaliseert voor zowel query-prestaties als opslagkosten. Handmatig onderhoud voor het tunen van OPTIMIZE, VACUUM en ANALYZE statements is niet langer nodig.

De implementatie van de nieuwe visie van Databricks is veelbelovend, maar…

De verschuiving van lakehouse platform naar data intelligence platform die Databricks doormaakt, is indrukwekkend. En ook nodig om de concurrentie voor te blijven.

De nieuwe en verbeterde functionaliteiten zijn startklaar, maar verdienen soms nog wel wat aandacht om écht de belofte van een allround data intelligence platform waar te kunnen maken.

Daarnaast is het goed om te weten dat wanneer je optimaal gebruik wil maken van alle nieuwe en verbeterde functionaliteiten, je soms een kostbare en tijdrovende migratie nodig hebt van al bestaande implementaties.

Geschreven door

Riviq

info@riviq.nl

+31 (0)70 40 60 966

Op de hoogte blijven van de laatste ontwikkelingen en webinars?

Schrijf je dan in voor de nieuwsbrief en ontvang circa 6x per jaar een selectie van blogs, cases, webinars en nieuws in je mailbox.

*Na inschrijving ga je akkoord met onze privacy policy

Meer over dit onderwerp

Maak een einde aan discussies over je data – Start een business glossary

Het is weer tijd om de maandelijkse cijfers te bespreken. Maar al snel merk je: de meeting verzandt opnieuw in een discussie over de data. Zo kom je natuurlijk geen steek verder. Hoe voorkom je dat nou? Pascal Snijders, projectmanager Data, Reporting & Analytics,...

5 tips om het gebruik van dashboards door je business te verhogen

Een flink arsenaal aan dashboards, maar bitter weinig gebruik ervan. Voor veel organisaties is het een dagelijkse realiteit. De meest voorkomende reden? De business wantrouwt de data en duikt liever in eigen Excels. De sleutel ligt daarom niet in nóg een...

Zo maak je datakwaliteit zichtbaar en bespreekbaar met Microsoft Purview

Laten jouw mensen je BI-rapportages links liggen? Grote kans dat het komt vanwege de datakwaliteit. Want hoe lager de datakwaliteit, hoe minder vertrouwen er is in je rapportages. Om dat vertrouwen op te krikken, moet je datakwaliteit zichtbaar én bespreekbaar maken....